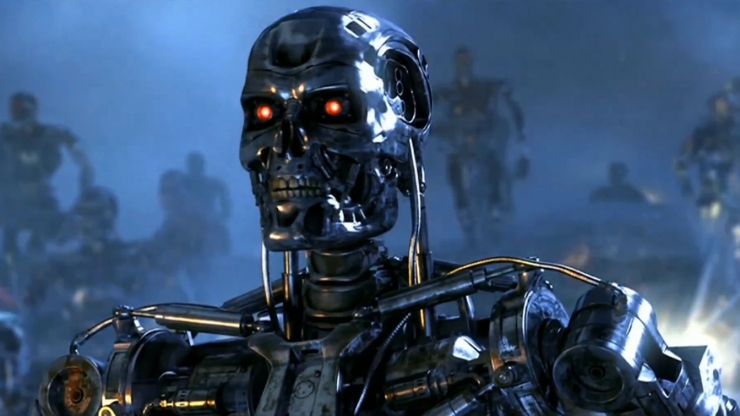

В научной фантастике полно очень злых роботов с искусственным интеллектом: от сайлонов до Терминатора, от Скайнета до недавнего Альтрона. Но все эти роботы были созданы с добрыми намерениями, и их жестокость была скорее неожиданным последствием программы, а не запланированной чертой разума. Но если причина будет крыться не в ошибке, а в преднамеренном замысле? Новое исследование посвящено именно этому вопросу: что если кто-то решит создать искусственный интеллект не для созидания, а для разрушения?

Статья под названием «Неэтичные исследования: как создать злонамеренный искусственный интеллект» Романа Ямпольского, сотрудника университета Луисвилля, и футуролога Федерико Пистоно исследует вопрос того, какой вред может принести человечеству активно действующая программа с разрушительными намерениями. Казалось бы, зачем вообще заниматься такими вопросами? Но исследователи говорят, что лучше опознать угрозу раньше, в спокойной и мирной обстановке, чем адаптироваться по ходу дела, когда такой ИскИн начнет свою атаку. Статья была написана в рамках гранта, выданного фондом Илона Маска, который еще раньше назвал «искусственные интеллекты одной из самых мощных угроз для человечества в будущем».

Что же выяснили Пистоно и Ямпольский? Их список групп, способных создать зловредного ИскИна начинается со знакомых позиций — военные (разрабатывающие кибервооружение и робосолдат), правительство (пытающееся использовать ИскИнов для установления собственной гегемонии, контроля над людьми и борьбы с другими странами), корпорации (попытка монополизации и устранения конкурентов) — а продолжается хакерами, религиозными культами и даже обыкновенными преступниками. И подобные искусственные интеллекты могут возникнуть в самых неожиданных местах. По версии авторов, код, написанный без присмотра, или закрытые программные проекты, составленные так, чтобы их видело как можно меньше людей, могут стать источниками неожиданного появления ИскИнов в мире.

Но что же зловредный ИскИн сможет сделать на самом деле? К примеру, подорвать рынок труда. Пистоно и Ямпольский пишут: «Используя естественную тенденцию компаний увеличивать производство и прибыли, злонамеренный ИскИн может предложить свои услуги корпорациям, и стать эффективнее большинства (если вообще не всех) сотрудников-людей, в результате чего корпорации в погони за прибылью создадут искусственную безработицу, не просчитав возможные риски».

Также одной из центральных угроз со стороны ИскИна исследователи считают манипулятивную пропаганду, с помощью которой искусственный интеллект может продвигать свои целы, используя законодательные органы человеческого общества. Он может развязать настоящую войну посредством подкупа через финансовые фонды, или посредством агрессивной пропаганды поссорить различные страны друг с другом, при этом люди во многом будут даже не понимать, откуда идет поток фальсификаций. Ну, и естественно, остается угроза уничтожения человечества с помощью созданного ИскИном патогена, или же существующего ядерного арсенала.

В ответ на критические и скептические замечания относительно преждевременности подобных исследований Ямпольский ссылается на недавнюю историю с чатботом Тау, который всего за пару дней общения с пользователями Твиттера превратился в расиста и человеконенавистника. Пусть данный пример лишь косвенно относится к поднятой проблеме, но Ямпольский акцентирует внимание исследователей на том, что инцидент выявил непредсказуемость подобного рода систем, и что даже сами создатели Тау не ожидали подобного исхода.