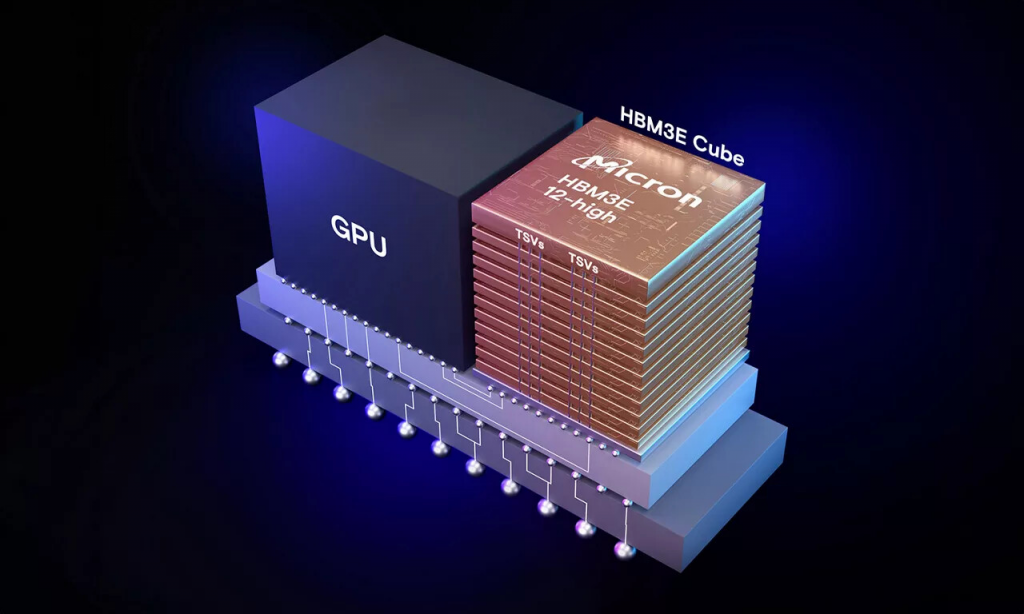

Micron Technology объявила о начале пробных поставок 12-уровневых (12-Hi) чипов памяти HBM3E, предназначенных для высокопроизводительных ИИ-ускорителей. Они проходят сертификацию в рамках партнёрской экосистемы, после чего начнется массовое производство. Новые чипы обладают емкостью 36 ГБ, что на 50 % больше по сравнению с текущими 8-слойными версиями HBM3E (24 ГБ). Кроме того, Micron заявляет о значительном снижении энергопотребления. Благодаря использованию 12-уровневых чипов HBM3E, крупные модели ИИ, такие как Llama 2 с 70 миллиардами параметров, могут быть запущены на одном ускорителе.

Пропускная способность выше 9,2 Гбит/с на контакт, что в общей сложности обеспечивает более 1,2 Тбайт/с. Новая память позволит гиперскейлерам и крупным операторам дата-центров масштабировать растущие рабочие нагрузки ИИ в соответствии с потребностями клиентов.

Компания Micron реализовала полностью программируемую функцию MBIST (Memory Built-In Self Test), способную работать на скоростях, соответствующих системному трафику. Это повышает эффективность тестирования, сокращает время вывода продукции на рынок и улучшает надёжность оборудования. При производстве памяти HBM3E Micron использует современные методы упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via).

Важно отметить, что компания Samsung анонсировала разработку 12-слойных чипов HBM3E с объёмом 36 ГБ в начале 2024 года. Эти решения обеспечивают пропускную способность до 1,28 ТБ/с, что, согласно заявлению, более чем на 50 % превосходит имеющиеся на рынке 8-слойные стеки HBM3. Ожидается, что массовое производство 12-Hi модулей HBM3E от SK hynix с ПСП 1,15 ТБ/с начнётся в октябре.

По материалам:

servernews