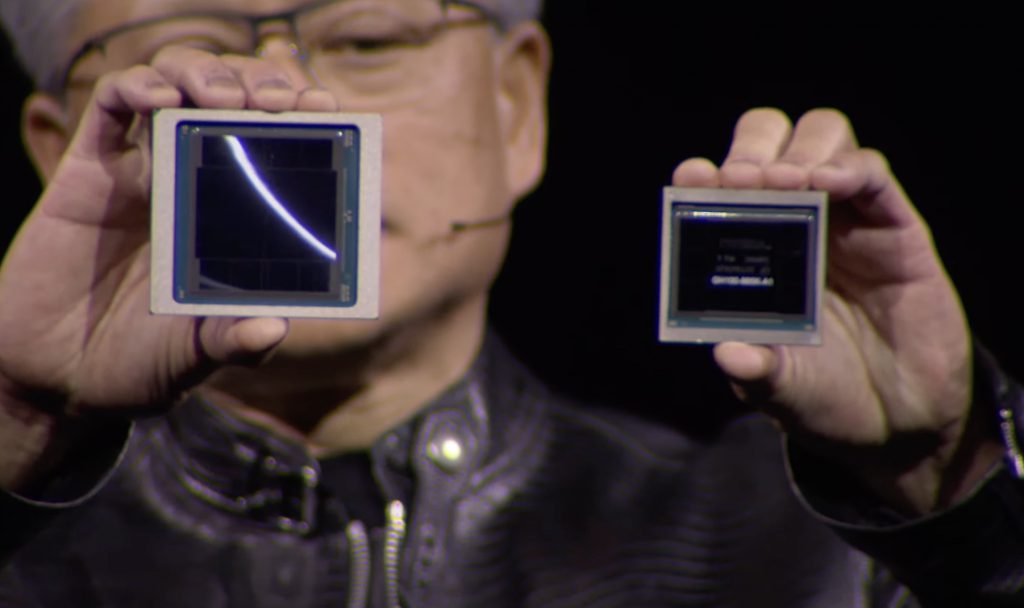

С помощью графического процессора H100 для поддержки искусственного интеллекта, NVIDIA стала лидером в этой сфере и получила миллиардные прибыли. Несмотря на то, что конкуренты стремятся догнать ее, догнать NVIDIA может быть сложно, так как вчера, 18 марта, они представили новый графический процессор Blackwell B200, достигающий невероятной производительности в 20 петафлопс на базе FP4. Такой производительности удалось достичь благодаря 208 млрд транзисторов. Но компания не останавливается на достигнутом.

NVIDIA также представила новый графический процессор GB200, назвав его «суперчипом». Это два объединенных процессора Blackwell B200 для повышения производительности и эффективности при выполнении задач и обеспечения 30-кратного увеличения производительности при работе с большими языковыми моделями. Это настоящий прорыв, поскольку глава NVIDIA заявил, что новый суперчип снижает энергопотребление на 25% по сравнению с процессором H100. Это значительно снизит расходы для корпоративного сектора и центров обработки данных, использующих сотни или тысячи таких систем.

Например, глава NVIDIA заявил, что для обучения большой языковой модели с 1.8 трлн параметров раньше требовалось 8000 графических процессоров Hopper и 15 мегаватт энергии. Однако, с новыми графическими ускорителями достаточно всего 2000 процессоров Blackwell и только 4 мегаватта энергии. NVIDIA осознает, что такие графические ускорители объединят в кластеры, поэтому компания представила новое поколение коммутаторов NVLink. Этот коммутатор позволяет 576 графическим процессорам обмениваться данными со скоростью 1.8 ТБ/сек.

Это позволяет решить проблему, когда раньше кластер из 16 графических процессоров тратил 60% времени на взаимодействие между компонентами и только 40% — на фактические вычисления. На презентации NVIDIA также представила готовые решения, такие как GB200 NVL72, которые включают 36 центральных и 72 графических процессора, систему водяного охлаждения и 5000 кабелей общей длиной 3 км. Такая система обеспечивает общую производительность ИИ-обучения 720 петафлопс и может работать с большой языковой моделью до 27 трлн параметров. Для сравнения, GPT-4 имеет только 1,7 трлн параметров, по некоторым данным.

По материалам:

trashbox