Red Hat анонсировала Red Hat Enterprise Linux AI (RHEL AI) — базовую платформу, которая повысит эффективность разработки, тестирования и запуска генеративных моделей искусственного интеллекта (ИИ) для поддержки корпоративных приложений. Это специализированный дистрибутив, содержащий основные модели, инструменты для работы с ними и соответствующие драйверы.

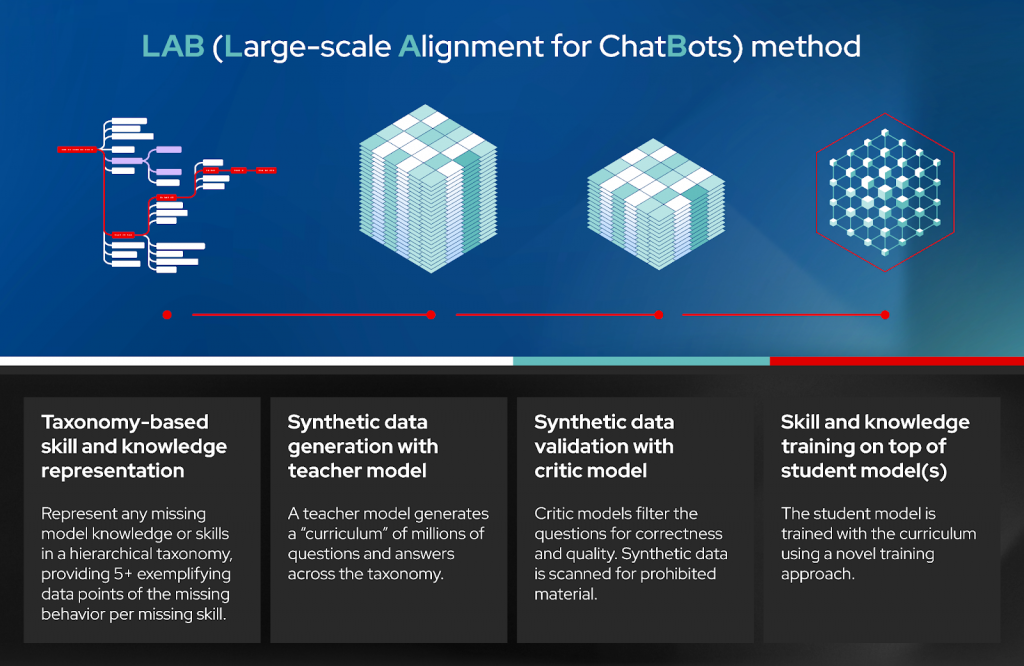

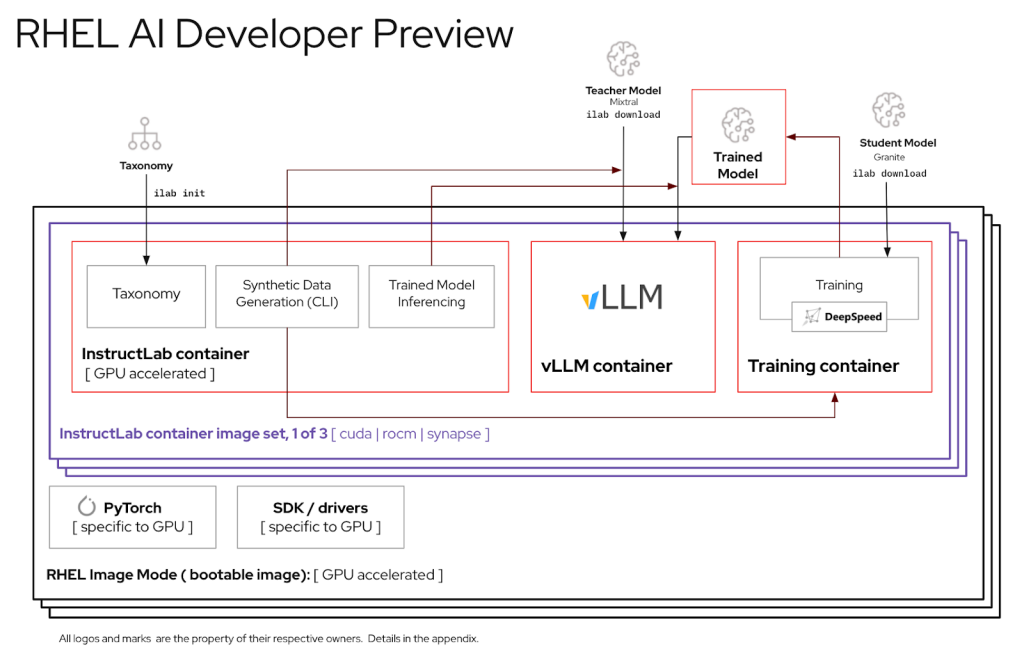

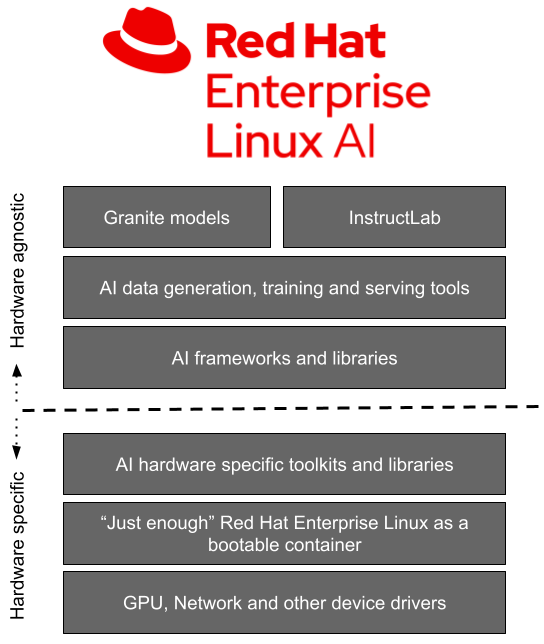

Сейчас платформа RHEL AI доступна разработчикам в качестве предварительной версии. Она включает семейство больших языковых моделей (LLM) IBM Granite, которые недавно стали доступны под лицензией Apache 2.0. Также она предлагает инструмент InstructLab для настройки и улучшения моделей с использованием методики LAB (Large-Scale Alignment for Chatbots). Кроме того, платформа предоставляет различные библиотеки и фреймворки.

Решение представлено в виде готового образа для развёртывания и является частью MLOps-платформы OpenShift AI. По информации от Red Hat, RHEL AI обеспечивает поддерживаемую и готовую к корпоративному использованию среду для работы с ИИ-моделями на платформах AMD, Intel и NVIDIA. Компания утверждает, что открытый исходный код поможет преодолеть трудности в реализации стратегии в сфере ИИ, связанные с нехваткой навыков обработки данных и финансовых ресурсов.

Главная задача RHEL AI и проекта InstructLab — предоставить специалистам в определённой области возможность напрямую участвовать в развитии больших языковых моделей, применяя свои знания и навыки. Новая платформа позволит им эффективнее создавать приложения на базе искусственного интеллекта, например, чат-ботов. В дальнейшем, если у вас есть подписка на RHEL AI, компания предложит поддержку корпоративного уровня на всех этапах жизненного цикла продукта, начиная с модели Granite 7B и программного обеспечения и заканчивая возможностью возмещения ущерба, связанного с интеллектуальной собственностью.

«Опираясь на инфраструктуру GPU, доступную в IBM Cloud, которая используется для обучения моделей Granite и поддержки InstructLab, IBM Cloud получит поддержку RHEL AI и OpenShift AI. Эта интеграция позволит предприятиям легче внедрять генеративный ИИ в свои критически важные приложения», — отметила компания.

Однако в настоящее время для запуска RHEL AI необходимы высокопроизводительные сертифицированные системы с ускорителями, объём памяти которых составляет минимум 320 ГБ, а хранилище имеет ёмкость от 200 ГБ. Тестировались серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X и инстансы IBM Cloud GX3. В скором времени планируется поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

По материалам:

servernews