AWS и NVIDIA объявили о нескольких новых совместных решениях для генеративного ИИ. Основной новостью является появление DGX Cloud на платформе AWS. Однако, это облако отличается от предыдущих версий DGX Cloud использованием гибридных суперчипов GH200 в новой конфигурации.

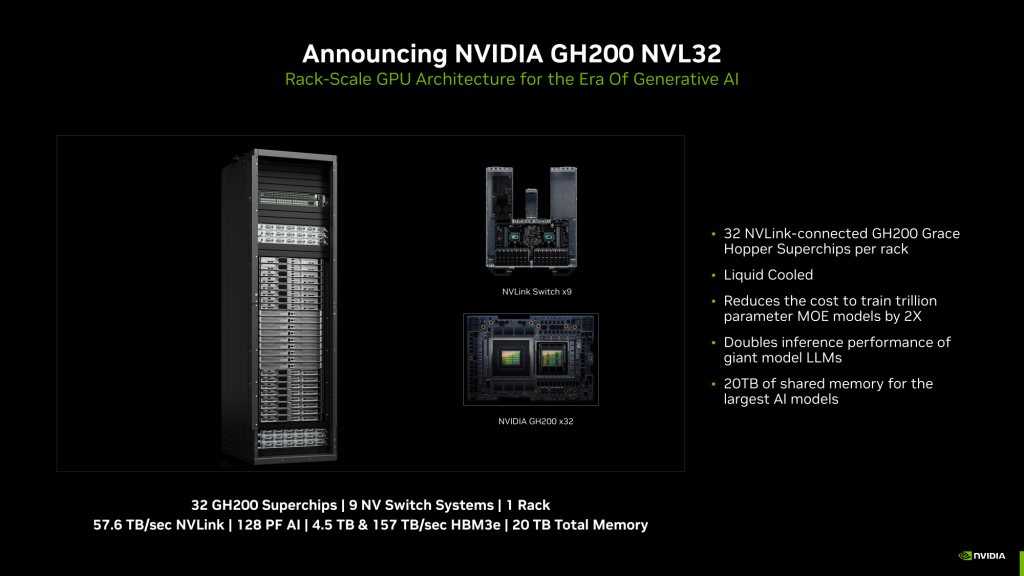

AWS DGX Cloud основан на платформе GH200 NVL32. Эта платформа включает 32 ускорителя GH200, связанных интерконнектом NVLink с пропускной способностью 900 Гбайт/с. Каждый ускоритель содержит 9 коммутаторов NVSwitch и 16 двухчиповых узлов с водяным охлаждением. NVIDIA утверждает, что GH200 NVL32 отлично подходит для обучения и инференса больших LLM с 1 триллионом параметров.

На основе этих данных можно вычислить, что AWS DGX Cloud имеет общую вычислительную мощность 128 Пифлопс (FP8), объем оперативной памяти 20 ТБ, из которых 4,5 ТБ приходится на память HBM3e с общей пропускной способностью 157 ТБ/с, и суммарную скорость NVLink 57,6 ТБ/с. Эта платформа использует специализированные DPU AWS Nitro и обеспечивает подключение EFA (400 ГБ/с на каждый узел). Новые инстансы могут быть объединены в кластеры EC2 UltraClusters.

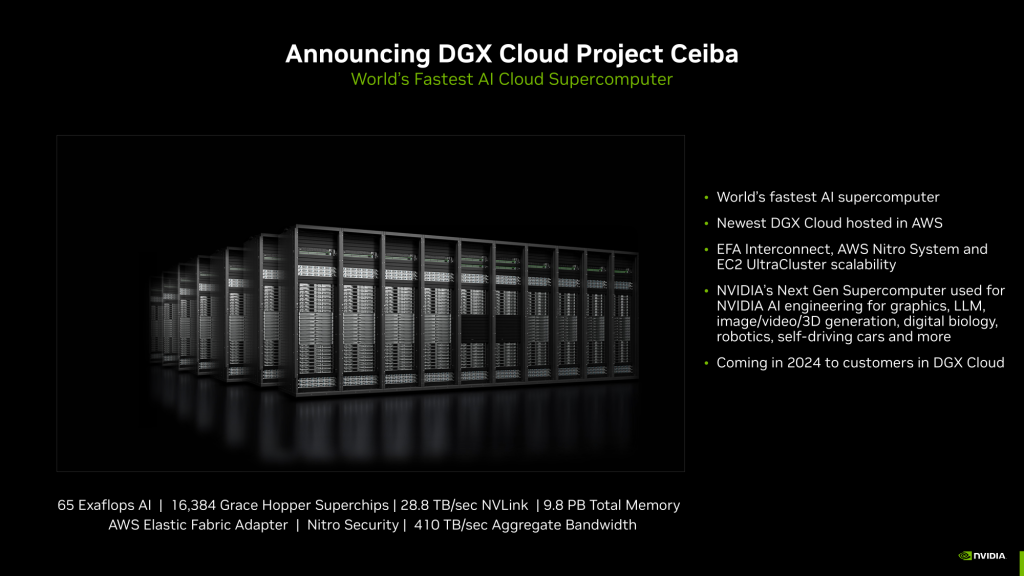

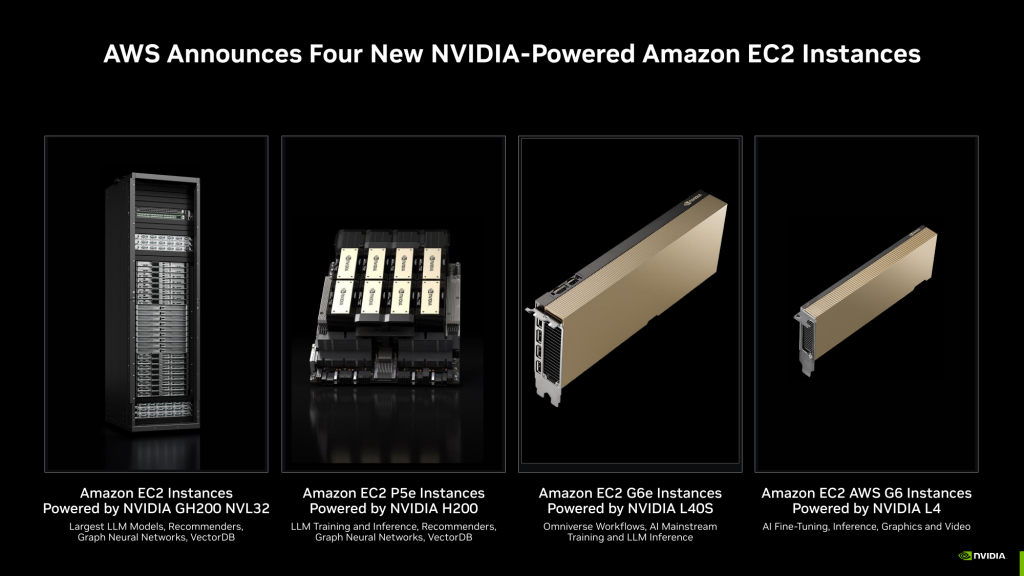

Одним из примеров такого кластера является Project Ceiba, который станет самым мощным в мире суперкомпьютером для ИИ с производительностью 65 Эксафлопс. Он будет состоять из 16 384 ускорителей GH200 и иметь общую память 9,1 Петабайт. Этот суперкомпьютер будет частью AWS DGX Cloud и будет доступен в начале 2024 года. Также в скором времени будут доступны более простые EC2-инстансы: P5e с NVIDIA H200, G6e с L40S и G6 с L4.

Источник servernews