NVIDIA представила набор программного обеспечения NVIDIA Magnum IO, позволяющее исследователям в области ИИ и HPC обрабатывать большие объемы данных за считанные минуты вместо нескольких часов. Помимо этого, компания объявила о референсной платформе для создания GPU-ускоренных серверов на базе ARM и анонсировала GPU-ускоренный суперкомпьютер в облаке Microsoft Azure.

NVIDIA разработала Magnum IO в сотрудничестве с DataDirect Networks, Excelero, IBM, Mellanox, WekaIO и др. ПО устраняет узкие места при хранении и передаче данных, ускоряя обработку массивов данных в многосерверных мульти-GPU вычислительных узлах и позволяя быстро выполнять финансовый анализ, моделирование климата и другие HPC-задачи.

В основе Magnum IO лежит технология GPUDirect, позволяющая данным обходить CPU и перемещаться по магистралям, созданным графическими процессорами, накопителями и сетевыми устройствами. GPUDirect совместима с широким спектром интерфейсов и API, включая NVIDIA NVLink и NCCL, а также OpenMPI и UCX, и состоит из одноранговых (peer-to-peer) и RDMA элементов.

Новым элементом является GPUDirect Storage, позволяющий исследователям в обход CPU получать доступ к хранимым файлам для моделирования, анализа и визуализации.

NVIDIA Magnum IO уже доступно, за исключением GPUDirect Storage, к которому пока только открыт ранний доступ. Широкая доступность GPUDirect Storage запланирована на первое полугодие 2020 года.

Помимо этого, компания представила референсную платформу для создания GPU-ускоренных серверов на базе ARM, которая состоит из аппаратных и программных блоков.

Для создания платформы NVIDIA объединилась с ARM и ее партнерами, включая Ampere, Fujitsu и Marvell, чтобы гарантировать беспроблемную работу GPU NVIDIA с процессорами ARM. Также она сотрудничает с Cray и Hewlett Packard Enterprise. Поставщики HPC ПО, в свою очередь, создали GPU-ускоренные инструменты управления и мониторинга с помощью библиотек NVIDIA CUDA-X, которые работают на ARM-серверах. Ознакомительный доступ к ARM-совместимому пакету инструментов разработки ПО, который включает библиотеки NVIDIA CUDA-X и инструменты разработки для ускоренных вычислений, уже открыт.

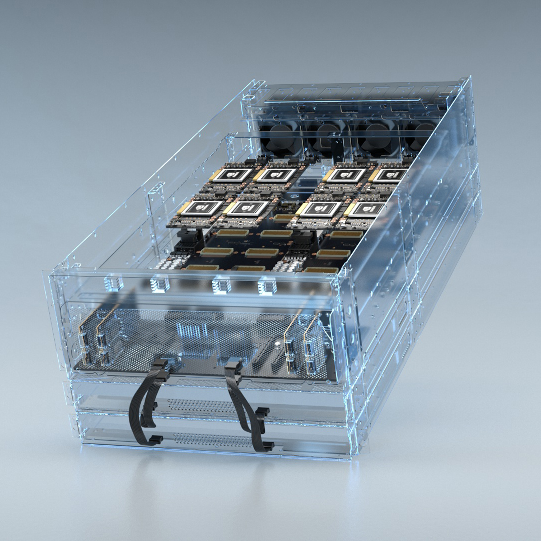

Анонсированный GPU-ускоренный суперкомпьютер в облаке Microsoft Azure предназначен для сложных ИИ- и высокопроизводительных (HPC) вычислений системы на базе нового инстанса Azure NDv2.

По словам компании, пользователи смогут арендовать целый ИИ-суперкомпьютер прямо на своем рабочем месте и сопоставить его возможности с возможностями локальных суперкомпьютеров. Один NDv2 инстанс обеспечивает производительность на порядок выше по сравнению с традиционным HPC-узлом без GPU-ускорения в приложениях такого типа, как глубокого обучение. При этом производительность можно линейно увеличивать, объединяя сотни инстансов, для масштабного моделирования.

Все NDv2 инстансы оптимизированы для GPU-ускоренных HPC приложений, ПО для машинного обучения и фреймворков глубокого обучения, таких как TensorFlow, PyTorch и MxNet из репозитария контейнеров NVIDIA NGC и Azure Marketplace. Репозитарий также поддерживает пакеты Helm для установки ИИ-программ на кластерах Kubernetes.

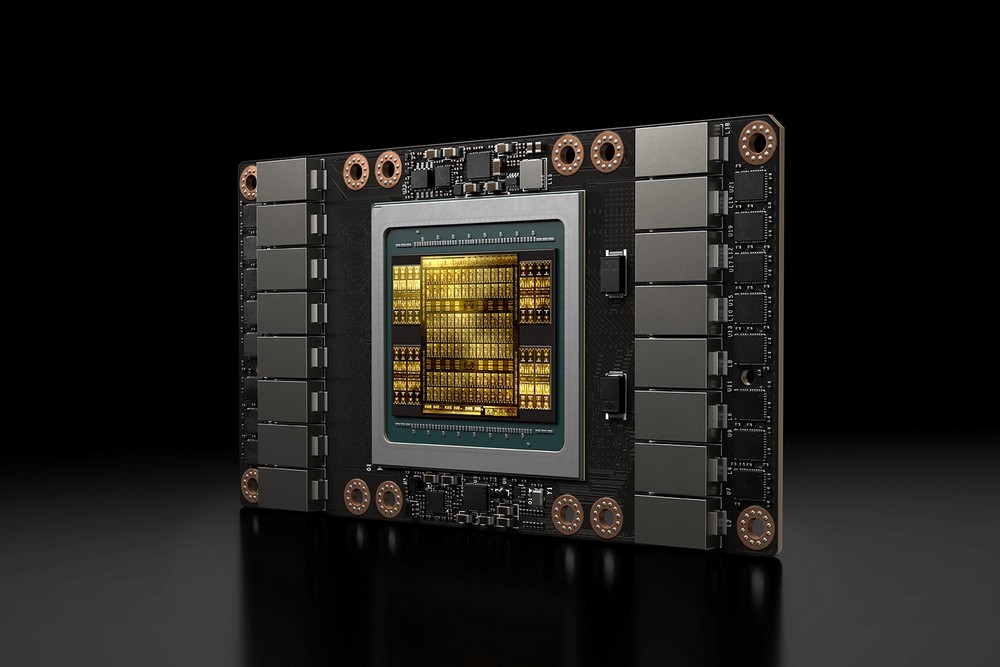

NDv2 уже доступны в режиме предварительного просмотра. Инстансы с восьмью GPU NVIDIA V100 можно объединять в кластеры.