Облачная платформа Microsoft Azure продолжает внедрять технологии HPC и ИИ. Компания Microsoft анонсировала новую серию виртуальных машин ND A100 v4. Это самые мощные масштабируемые инстансы для обработки данных с использованием искусственного интеллекта, которые объединяют от восьми до тысяч ускорителей NVIDIA на сотнях виртуальных машин.

Старший администратор проекта Ян Финдер (Ian Finder) сообщил в блоге компании, что серия ND A100 v4 начинается с одной виртуальной машины (ВМ) и восьми графических процессоров NVIDIA Ampere A100 с тензорными ядрами. Кластеры на базе ND A100 v4 могут масштабироваться до тысяч графических процессоров с пропускной способностью 1,6 Тбит/с на каждую виртуальную машину.

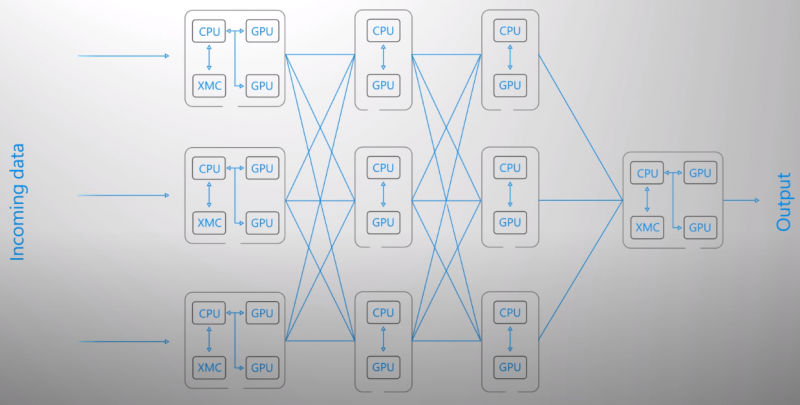

Каждый ускоритель снабжен собственным выделенным подключением NVIDIA Mellanox HDR InfiniBand 200 Гбит/с. Десятки, сотни или даже тысячи графических процессоров могут работать вместе как часть кластера с InfiniBand-фабрикой. Любая ИИ-задача, будь то обучение модели с нуля, дообучение с использованием ваших собственных данных или тонкий тюнинг для конкретной нагрузки, будет достигнута намного быстрее с выделенным подключением GPU↔GPU, которое в 16 раз быстрее любого другого решения от других провайдеров публичного облака.

Для серии виртуальных машин ND A100 v4 используется новая платформа AMD EPYC Rome с поддержкой стандарта PCIe Gen 4. Как утверждает Финдер, PCIe 4.0 и шина NVIDIA NVLink третьего поколения позволили более чем вдвое увеличить скорость перемещения данных в системе по сравнению с предыдущим поколением виртуальных машин. Клиенты, которые будут использовать новые возможности A100, такие как тензорные ядра и Multi-instance GPU (MIG), смогут добиться 20-кратного увеличения производительности.

Серия виртуальных машин ND A100 v4 в настоящее время находится на стадии предварительного доступа, после чего появится в портфолио Azure в качестве стандартного предложения. Ранее ускорители A100 появились в Google Cloud, а AWS обещает добавить их в своё облако в скором времени.